Konsolidacja obciążenia pracą jest dobra, prawda?

Konsolidacja obciążenia pracą to świetny pomysł: można zrobić więcej w krótszym czasie, obniżyć koszta oraz zwiększyć funkcjonalność. Dwa z głównych czynników wpływających na konsolidację obciążenia pracą to sztuczna inteligencja (AI) i uczenie maszynowe (ML). Zarówno sztuczna inteligencja, jak i uczenie maszynowe mogą być wdrożone w chmurze, ale w przypadku wielu zastosowań opóźnienie przetwarzania danych w chmurze sprawia, że nie można zastosować tych rozwiązań. Aby to zmienić, należy przenieść sztuczną inteligencję i uczenie maszynowe na brzeg sieci.

Jak można się spodziewać, takie rozwiązanie prowadzi do powstania kolejnych kwestii, które trzeba wziąć pod uwagę. Artykuł dotyczący konsolidacji obciążenia pracą i zabezpieczeń w kontekście AI i ML wyjaśnia, jak kwestia bezpieczeństwa wpływa na konsolidację obciążenia pracą. Wraz z rozwojem nowych procesorów i wyższym poziomem integracji mamy większy niż kiedykolwiek wcześniej dostęp do zasobów przetwarzania na brzegu sieci. Na przykład seria S32V2 firmy NXP umożliwia wdrożenie nowych poziomów przetwarzania wizyjnego i przetwarzania w sieci neuronowej w czasie rzeczywistym w szerokim zakresie zastosowań.

Jednym z ważnych aspektów, o którym należy pamiętać, jest to, że podczas wyprowadzenia przetwarzania danych na brzeg sieci, wyprowadzana jest również własność intelektualna (IP). Nikt nie chce ukraść algorytmu interpolacji w czujniku temperatury. Ale sztuczna inteligencja i uczenie maszynowe to dwie rozwijające się technologie. Wciąż trwają nad nimi prace i jest to trudny temat. Wciąż jest dużo miejsca na innowacje, a firmy wyróżniają swoje produkty na tle konkurencji sposobem, w jaki przetwarzają dane i wdrażają własne, złożone algorytmy. W miarę rozwoju tych technologii w pewnym momencie pojawią się biblioteki gotowych rozwiązań AI i ML, tak samo jak miało to miejsce w przypadku bibliotek graficznych, cyfrowego przetwarzania sygnału, rozpoznawania mowy i tysięcy innych technologii.

Jeszcze nie dotarliśmy to tego punktu, więc gdy własność intelektualna znajdzie się na brzegu sieci, jest podatna na zagrożenia. Konkurencja może ją wykraść, jeśli nie będzie chroniona. Im cenniejsza własność intelektualna przenoszona jest na brzeg sieci, tym ważniejsza jej ochrona. Nie można jej po prostu przechowywać w pamięci flash, ponieważ odczytanie kodu z magistrali pamięci jest stosunkowo prostym zadaniem. Kod musi być zaszyfrowany, a klucze kryptograficzne należy przechowywać w taki sposób, aby nie można było ich odczytać z mikroprocesora.

Ale nawet to nie wystarczy. Wciąż istnieją luki w samych procesorach. Jeśli haker może przesłać nowy kod w formie aktualizacji lub przez port debugowania, prosty program nadpisujący oprogramowanie układowe może wykorzystać silnik kryptograficzny procesora do odszyfrowania kodu i wyprowadzenia go przez port I2C.

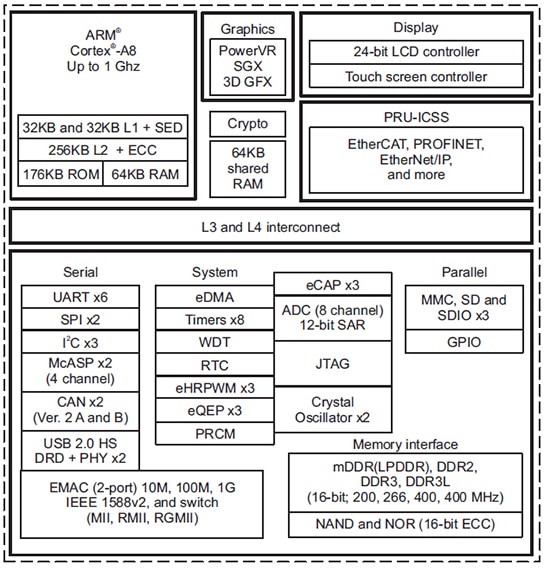

Aby chronić własność intelektualną, sam procesor również musi być zabezpieczony. Ma to swój początek w technologii bezpiecznego uruchamiania. Warto rozważyć zastosowanie procesora z serii Sitara firmy Texas Instruments (ilustracja 1). Wbudowane procesory tworzą zaufany moduł bezpieczeństwa weryfikujący oprogramowanie uruchamiające, zanim procesor rozpocznie wykonywanie jakiegokolwiek kodu. Na podstawie utworzonego w ten sposób modułu bezpieczeństwa (root of trust) można bezpiecznie załadować i uruchomić aplikację.

Ilustracja 1: schemat bloków funkcjonalnych mikroprocesora Sitara AM335x firmy Texas Instruments. (Źródło ilustracji: Texas Instruments)

Ilustracja 1: schemat bloków funkcjonalnych mikroprocesora Sitara AM335x firmy Texas Instruments. (Źródło ilustracji: Texas Instruments)

Konsolidacja obciążenia pracą na brzegu sieci pozwala systemom na lokalne wykonywanie większej ilości pracy i osiągnięcie większej funkcjonalności poprzez dostęp do danych w czasie rzeczywistym. Jednocześnie systemy te muszą być lepiej chronione, by nie została ujawniona własność intelektualna. Własność intelektualną można chronić za pomocą nowoczesnych wbudowanych procesorów i zintegrowanych możliwości zabezpieczeń. Zatem tak, konsolidacja obciążenia pracą jest dobra.

Have questions or comments? Continue the conversation on TechForum, DigiKey's online community and technical resource.

Visit TechForum