Optymalizacja logistyki wewnętrznej w celu usprawnienia i skrócenia łańcuchów dostaw w Przemyśle 4.0 - część druga z dwóch

Przekazane przez: Północnoamerykańscy redaktorzy DigiKey

2023-09-22

Część 1 niniejszej serii poświęconej intralogistyce omawia zagadnienia związane ze sposobem, w jaki autonomiczne roboty mobilne (AMR) i pojazdy kierowane automatycznie (AGV) są wykorzystywane na poziomie systemowym do wdrażania intralogistyki oraz szybkiego i bezpiecznego przemieszczania materiałów zależnie od potrzeb. W tym artykule skupiono się na przypadkach użycia i wykorzystaniu czujników w autonomicznych robotach mobilnych (AMR) i pojazdach kierowanych automatycznie (AGV) do identyfikacji i śledzenia przedmiotów, a także na tym, w jaki sposób uczenie maszynowe (ML) i sztuczna inteligencja (AI) wspierają identyfikację, przemieszczanie i dostarczanie materiałów w magazynach i zakładach produkcyjnych.

Intralogistyka (logistyka wewnętrzna) wykorzystuje autonomiczne roboty mobilne (AMR) i pojazdy kierowane automatycznie (AGV) w celu realizacji efektywnego transportu materiałów w magazynach i zakładach produkcyjnych Przemysłu 4.0. Aby usprawnić i skrócić łańcuchy dostaw, systemy intralogistyczne muszą znać aktualną lokalizację materiału, jego miejsce przeznaczenia oraz najbezpieczniejszą i najefektywniejszą drogę dotarcia tam. Tak usprawniona nawigacja wymaga różnorodnych czujników.

Do zwiększenia świadomości sytuacyjnej w rozwiązaniach intralogistyki, pojazdy kierowane automatycznie (AGV) i autonomiczne roboty mobilne (AMR) wykorzystują czujniki. Układy czujników zapewniają bezpieczeństwo pobliskiego personelu, ochronę innego sprzętu oraz sprawną nawigację i lokalizację. W zależności od wymagań zastosowania, technologie czujników do autonomicznych robotów mobilnych (AMR) mogą obejmować czujniki kontaktowe, takie jak łączniki krańcowe wbudowane w zderzaki, czujniki 2D i 3D wykrywania światła oraz pomiaru odległości (LiDAR), urządzenia ultradźwiękowe, kamery stereoskopowe i 2D, radary, enkodery, inercyjne jednostki pomiarowe (IMU) oraz fotokomórki. W przypadku pojazdów kierowanych automatycznie (AGV) czujniki mogą obejmować liniowe czujniki magnetyczne, indukcyjne lub optyczne, a także łączniki krańcowe wbudowane w zderzaki, czujniki 2D LiDAR i enkodery.

W pierwszym artykule z tej serii omówiono zagadnienia związane ze sposobem wykorzystania autonomicznych robotów mobilnych (AMR) i pojazdów kierowanych automatycznie (AGV) na poziomie systemowym w celu wdrożenia intralogistyki oraz efektywnego transportu materiałów zależnie od potrzeb.

Niniejszy artykuł koncentruje się na fuzji czujników oraz na sposobie, w jaki autonomiczne roboty mobilne (AMR) i pojazdy kierowane automatycznie (AGV) wykorzystują kombinacje czujników oraz sztuczną inteligencję (AI) i uczenie maszynowe (ML) do lokalizacji, nawigacji i zapewnienia bezpieczeństwa operacyjnego. Artykuł rozpoczyna się od krótkiego przeglądu najczęściej spotykanych czujników w pojazdach kierowanych automatycznie (AGV), analizuje algorytmy pozy robota oraz algorytmy funkcji jednoczesnych lokalizacji i mapowania (SLAM), wykorzystujące fuzję czujników oraz omawia sposób, w jaki można poprawić rezultaty funkcji jednoczesnych lokalizacji i mapowania (SLAM) dzięki technikom dopasowywania typu skan-mapa i skan-skan, a na koniec omawia, w jaki sposób fuzja czujników przyczynia się do bezpieczeństwa działania autonomicznych robotów mobilnych (AMR) i pojazdów kierowanych automatycznie (AGV). We wszystkich wspomnianych przypadkach firma DigiKey wspiera projektantów szeroką gamą czujników i łączników do robotyki i innych zastosowań przemysłowych.

Do obsługi autonomicznej pracy i zapewnienia bezpieczeństwa w autonomicznych robotach mobilnych (AMR) potrzebny jest szereg czujników i ich fuzja, sztuczna inteligencja (AI), uczenie maszynowe (ML) oraz łączność bezprzewodowa. Wymagania dotyczące parametrów działania dla pojazdów kierowanych automatycznie (AGV) są niższe, jednak nadal opierają się one na wielu czujnikach, aby zapewnić bezpieczną i wydajną pracę. Istnieją dwie najważniejsze kategorie czujników:

- Czujniki proprioceptywne mierzą wartości wewnętrzne robota, takie jak prędkość kół, obciążenie, poziom naładowania baterii itp.

- Czujniki eksteroceptywne dostarczają informacji o otoczeniu robota, takich jak pomiary odległości, lokalizacje punktów orientacyjnych i identyfikacja przeszkód, na przykład osób pojawiających się na drodze robota.

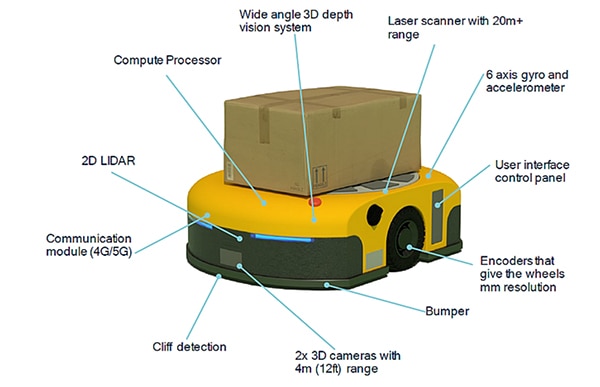

Fuzja czujników w pojazdach kierowanych automatycznie (AGV) i autonomicznych robotach mobilnych (AMR) polega na kombinacji czujników proprioceptywnych i eksteroceptywnych. Przykłady czujników w autonomicznych robotach mobilnych (AMR) (ilustracja 1):

- Skaner laserowy do wykrywania obiektów o zasięgu ponad 20m

- Inercyjna jednostka pomiarowa (IMU) z 6-osiowym żyroskopem i przyspieszeniomierzem, a czasami także magnetometrem

- Enkodery o rozdzielczości milimetrowej (mm) na kołach

- Czujnik dotykowy, na przykład mikroprzełącznik w zderzaku, który natychmiast zatrzymuje ruch w przypadku nieoczekiwanego kontaktu z obiektem

- Dwie skierowane do przodu kamery 3D o zasięgu 4m

- Czujnik skierowany w dół do wykrywania krawędzi platformy (tzw. wykrywanie uskoków)

- Moduły komunikacyjne zapewniające łączność, które mogą opcjonalnie oferować pomiar kąta nadejścia (AoA) i kąta wyjścia (AoD) z wykorzystaniem technologii Bluetooth dla usług lokalizacyjnych w czasie rzeczywistym (RTLS) lub punktów transmisji/odbioru 5G (TRP) do wykreślenia siatki z dokładnością rzędu centymetra

- Czujniki 2D LiDAR do obliczania odległości do przeszkód przed pojazdem

- Szerokokątny system widzenia głębi 3D odpowiedni do identyfikacji i lokalizacji obiektów

- Wbudowany wysokowydajny procesor obliczeniowy fuzji czujników, sztucznej inteligencji (AI) oraz uczenia maszynowego (ML)

Ilustracja 1: przykład ukazujący różnorodność i pozycje wbudowanych czujników autonomicznego robota mobilnego (AMR). (Źródło ilustracji: Qualcomm)

Ilustracja 1: przykład ukazujący różnorodność i pozycje wbudowanych czujników autonomicznego robota mobilnego (AMR). (Źródło ilustracji: Qualcomm)

Poza robota i fuzja czujników

Nawigacja w autonomicznych robotach mobilnych (AMR) jest skomplikowanym procesem. Jednym z pierwszych kroków dla autonomicznego robota mobilnego (AMR) jest ustalenie, gdzie się znajduje i w jakim kierunku jest zwrócony. Ta kombinacja danych nazywana jest pozą robota. Koncepcję pozy można również zastosować do ramion i efektorów końcowych wieloosiowych robotów stacjonarnych. Dzięki fuzji czujników dane wejściowe z inercyjnej jednostki pomiarowej (IMU), enkoderów i innych czujników są łączone w celu określenia pozycji. Algorytm pozy szacuje pozycję (x, y) robota i kąt orientacji θ względem osi współrzędnych. Funkcja q = (x, y, θ) określa pozę robota. W przypadku autonomicznych robotów mobilnych (AMR) informacje o pozie mają różne zastosowania, na przykład:

- Poza intruza, np. osoby zbliżającej się do robota, względem zewnętrznej ramki odniesienia lub względem robota

- Szacowana poza robota po przemieszczeniu się z określoną prędkością przez ustalony czas

- Obliczanie profilu prędkości potrzebnego robotowi do przejścia z bieżącej pozy do innej

Poza jest wstępnie zdefiniowaną funkcją w kilku środowiskach rozwojowych oprogramowania dla robotów. Na przykład otwartoźródłowa platforma rozwojowa Robot Operations System (ROS) zawiera pakiet robot_pose_ekf. Pakiet robot_pose_ekf może służyć do szacowania trójwymiarowej pozy robota na podstawie (częściowych) pomiarów pozy z różnych czujników. Wykorzystuje on rozszerzony filtr Kalmana z modelem 6D (pozycja 3D i orientacja 3D) do łączenia pomiarów z enkodera do pomiaru odległości kół, kamery do pomiaru przebytej drogi oraz inercyjnej jednostki pomiarowej (IMU). Ponieważ różne czujniki działają z różnymi szybkościami i latencjami, pakiet robot_pose_ekf nie wymaga, aby wszystkie dane z czujników były dostępne w sposób ciągły lub jednocześnie. Każdy czujnik służy do szacowania pozy z pewną kowariancją. Pakiet robot_pose_ekf identyfikuje dostępne informacje z czujników w dowolnym momencie i odpowiednio je dostosowuje.

Fuzja czujników oraz funkcja jednoczesnej lokalizacji i mapowania (SLAM)

W wielu środowiskach, w których działają autonomiczne roboty mobilne (AMR), występują przeszkody zmienne, które mogą się od czasu do czasu przemieszczać. Podstawowa mapa obiektu jest przydatna, jednak potrzeba czegoś więcej. Podczas poruszania się po obiekcie przemysłowym, autonomiczne roboty mobilne (AMR) potrzebują więcej niż tylko informacji o pozie. Wykorzystują one również funkcję jednoczesnych lokalizacji i mapowania (SLAM), aby zapewnić sprawne działanie. Funkcja jednoczesnych lokalizacji i mapowania (SLAM) wzbogaca zdolność nawigowania o mapowanie środowiska w czasie rzeczywistym. Dwa podstawowe podejścia do funkcji jednoczesnych lokalizacji i mapowania (SLAM) to:

- Wizualna funkcja jednoczesnych lokalizacji i mapowania (SLAM) łącząca kamerę z inercyjną jednostką pomiarową (IMU)

- Funkcja jednoczesnych lokalizacji i mapowania (SLAM) w technologii LiDAR, która łączy czujnik laserowy, np. czujnik 2D lub 3D LiDAR, z inercyjną jednostką pomiarową (IMU)

Funkcja jednoczesnych lokalizacji i mapowania (SLAM) w technologii LiDAR może być dokładniejsza niż w technologii wizualnej, ale generalnie jest droższa we wdrożeniu. W celu poprawy szacunków wizualnej funkcji jednoczesnych lokalizacji i mapowania (SLAM), do dostarczania informacji o lokalizacji można również wykorzystać technologię 5G. Wykorzystanie prywatnych sieci 5G w magazynach i fabrykach może poprawić funkcjonowanie wbudowanych czujników funkcji jednoczesnych lokalizacji i mapowania (SLAM). Niektóre autonomiczne roboty mobilne (AMR) są wyposażone w funkcje precyzyjnego pozycjonowania w pomieszczeniach z wykorzystaniem punktów nadawania-odbioru (TRP) 5G w celu wykreślenia siatki z dokładnością rzędu centymetra na osiach x, y i z.

Skuteczna nawigacja zależy od zdolności autonomicznych robotów mobilnych (AMR) do dostosowywania się do zmieniających się warunków środowiskowych. Na potrzeby nawigacji łączy się wizualną funkcję jednoczesnych lokalizacji i mapowania (SLAM) z funkcją jednoczesnych lokalizacji i mapowania (SLAM) w technologii LiDAR oraz technologiami nakładkowymi, takimi jak 5G TRP i uczeniem maszynowym (ML) w celu wykrywania zmian w środowisku i zapewniania ciągłych aktualizacji lokalizacji. Fuzja czujników wspiera funkcję jednoczesnych lokalizacji i mapowania (SLAM) na kilka sposobów:

- Ciągłe aktualizacje przestrzennego i semantycznego modelu środowiska w oparciu o dane wejściowe z różnych czujników, wykorzystujących sztuczną inteligencję (AI) i uczenie maszynowe (ML)

- Identyfikacja przeszkód, pozwalająca algorytmom planowania ścieżki na dokonywanie niezbędnych korekt i znalezienie najbardziej wydajnej ścieżki w otoczeniu

- Wdrożenie planu ścieżki wymagające sterowania w czasie rzeczywistym w celu zmiany zaplanowanej ścieżki, w tym prędkości i kierunku działania autonomicznego robota mobilnego (AMR) w odpowiedzi na zmiany w otoczeniu

Gdy funkcja jednoczesnych lokalizacji i mapowania (SLAM) to za mało

Funkcja jednoczesnych lokalizacji i mapowania (SLAM) jest kluczowym narzędziem efektywnej nawigacji autonomicznych robotów mobilnych (AMR), ale sama w sobie jest niewystarczająca. Podobnie jak algorytmy pozy, funkcja jednoczesnych lokalizacji i mapowania (SLAM) jest implementowana przy wykorzystaniu rozszerzonego filtra Kalmana, który zapewnia szacunkowe wartości. Szacowane wartości z funkcji jednoczesnych lokalizacji i mapowania (SLAM) rozszerzają dane pozy, między innymi o prędkości liniowe i obrotowe oraz przyspieszenia liniowe. Szacowanie w funkcji jednoczesnych lokalizacji i mapowania (SLAM) jest procesem dwuetapowym; pierwszy krok polega na sporządzeniu prognoz z wykorzystaniem wewnętrznych analiz z czujników opartych na fizycznych prawach ruchu. Drugi etap szacowania funkcji jednoczesnych lokalizacji i mapowania (SLAM) wymaga odczytów z czujników zewnętrznych w celu udoskonalenia wstępnych szacunków. Ten dwuetapowy proces pomaga eliminować i korygować niewielkie błędy, które mogą z czasem ulec skompilowaniu i spowodować poważne błędy.

Funkcja jednoczesnych lokalizacji i mapowania (SLAM) polega na dostępności danych wejściowych z czujników. Stosunkowo tanie czujniki 2D LiDAR mogą nie działać w niektórych przypadkach, na przykład gdy w bezpośredniej linii widzenia czujnika nie ma żadnych obiektów. W takich przypadkach parametry działania systemu mogą poprawić kamery 3D stereo lub czujniki 3D LiDAR. Jednak kamery 3D stereo i czujniki 3D LiDAR są droższe, a ich wdrożenie wymaga większej mocy obliczeniowej.

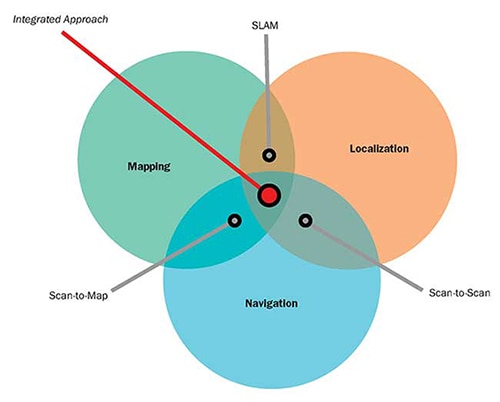

Inną alternatywą jest użycie systemu nawigacyjnego, który integruje funkcje jednoczesnych lokalizacji i mapowania (SLAM) z technikami dopasowania typu skan-mapa i skan-skan, które można wdrożyć przy użyciu tylko czujników 2D LiDAR (ilustracja 2):

- W dopasowaniu typu skan-mapa do oszacowania pozycji autonomicznego robota mobilnego (AMR) wykorzystuje się dane odległościowe, pozyskane dzięki wykorzystaniu technologii LiDAR poprzez dopasowanie pomiarów odległościowych do zapisanej mapy. Skuteczność tej metody zależy od dokładności mapy. Charakteryzuje się ona brakiem dryftu w czasie, ale w powtarzających się środowiskach może wywoływać błędy, które będą trudne do zidentyfikowania i wyeliminowania oraz będą powodować nieciągłe zmiany w postrzeganej pozycji.

- W dopasowaniu typu skan-skan do oszacowania pozycji autonomicznego robota mobilnego (AMR), pomiędzy skanami wykorzystuje się sekwencyjne dane odległościowe, pozyskane dzięki wykorzystaniu technologii LiDAR. Ta metoda zapewnia zaktualizowane informacje o lokalizacji i pozycji autonomicznego robota mobilnego (AMR) niezależnie od posiadanych map i może być przydatna podczas tworzenia map. Jest to jednak algorytm inkrementalny, który może podlegać dryftowi w czasie, bez możliwości identyfikacji spowodowanych przez to niedokładności.

Ilustracja 2: do uzupełnienia i poprawy parametrów działania funkcji jednoczesnych lokalizacji i mapowania (SLAM) można wykorzystać algorytmy dopasowywania typu skan-mapa i skan-skan. (Źródło ilustracji: Aethon)

Ilustracja 2: do uzupełnienia i poprawy parametrów działania funkcji jednoczesnych lokalizacji i mapowania (SLAM) można wykorzystać algorytmy dopasowywania typu skan-mapa i skan-skan. (Źródło ilustracji: Aethon)

Bezpieczeństwo wymaga fuzji czujników

W przypadku pojazdów kierowanych automatycznie (AGV) i autonomicznych robotów mobilnych (AMR) bezpieczeństwo jest kluczową kwestią, dlatego należy wziąć pod uwagę kilka norm. Na przykład normę B56.5 - 2019 pt. „Norma bezpieczeństwa dla bezzałogowych, automatycznie kierowanych pojazdów przemysłowych i zautomatyzowanych funkcji załogowych pojazdów przemysłowych Amerykańskiego Instytutu Norm Krajowych (American National Standards Institute, ANSI) / Fundacji ds. opracowywania przemysłowych norm dla pojazdów ciężarowych (Industrial Truck Standards Development Foundation, ITSDF), normę R15.08-1-2020 pt. „Norma dla przemysłowych robotów mobilnych - wymagania bezpieczeństwa” Amerykańskiego Instytutu Norm Krajowych (American National Standards Institute, ANSI) / Stowarzyszenia Robotów Przemysłowych (Robotic Industrial Association, RIA), kilka norm Międzynarodowej Organizacji Normalizacyjnej (ISO) i inne.

Bezpieczna eksploatacja pojazdów kierowanych automatycznie (AGV) i autonomicznych robotów mobilnych (AMR) wymaga fuzji czujników, która będzie łączyć w sobie posiadające certyfikaty bezpieczeństwa czujniki 2D LiDAR (czasami nazywane laserowymi skanerami bezpieczeństwa) z enkoderami na kołach. Czujniki 2D LiDAR wykrywają jednocześnie dwie odległości, mogą działać pod kątem pomiarów 270° i uwzględniają prędkości pojazdów podawane przez enkodery. Po wykryciu obiektu w dalszej strefie wykrywania (w odległości do 20m, w zależności od czujnika) prędkość pojazdu może w razie potrzeby zostać zmniejszona. Jeśli obiekt znajdzie się w bliższej strefie wykrywania na linii przejazdu, pojazd się zatrzyma.

Laserowe skanery bezpieczeństwa są często używane w zestawach po 4 sztuki, po jednej w każdym narożniku pojazdu. Mogą one działać jako pojedyncze jednostki i komunikować się bezpośrednio z kontrolerem bezpieczeństwa w pojeździe. Skanery są dostępne i certyfikowane do użytku w zastosowaniach kategorii bezpieczeństwa 3, poziomu zapewnienia bezpieczeństwa d (PLd) i poziomu nienaruszalności bezpieczeństwa 2 (SIL2). Zamknięte są w obudowie IP65, odpowiedniej do większości zastosowań zewnętrznych, jak i wewnętrznych (ilustracja 3). Na potrzeby obsługi fuzji czujników skanery zawierają wejście dla informacji z enkoderów inkrementalnych kół.

Ilustracja 3: tego typu czujniki 2D LiDAR można łączyć z enkoderami na kołach w ramach systemu fuzji czujników, który zapewni bezpieczną pracę autonomicznych robotów mobilnych (AMR) i pojazdów kierowanych automatycznie (AGV). (Źródło ilustracji: Idec)

Ilustracja 3: tego typu czujniki 2D LiDAR można łączyć z enkoderami na kołach w ramach systemu fuzji czujników, który zapewni bezpieczną pracę autonomicznych robotów mobilnych (AMR) i pojazdów kierowanych automatycznie (AGV). (Źródło ilustracji: Idec)

Podsumowanie

Intralogistyka zapewnia krótsze i sprawniejsze łańcuchy dostaw w magazynach i fabrykach Przemysłu 4.0. Autonomiczne roboty mobilne (AMR) i pojazdy kierowane automatycznie (AGV) są ważnymi narzędziami w intralogistyce, umożliwiającymi transport materiałów z miejsca na miejsce w sposób szybki i bezpieczny. Fuzja czujników jest niezbędna do wspierania działania autonomicznych robotów mobilnych (AMR) i pojazdów kierowanych automatycznie (AGV), m.in. służąc do określania ich póz, obliczania danych z wykorzystaniem funkcji jednoczesnych lokalizacji i mapowania (SLAM), poprawy parametrów nawigacyjnych dzięki dopasowaniu typu skan-mapa i skan-skan, a także zapewniając bezpieczeństwo personelu i obiektów w całym zakładzie.

Disclaimer: The opinions, beliefs, and viewpoints expressed by the various authors and/or forum participants on this website do not necessarily reflect the opinions, beliefs, and viewpoints of DigiKey or official policies of DigiKey.